本文是一篇计算机论文,本文就“基于生成对抗网络的图像融合方法研究”这个课题进行了广泛的探索,结合显著性提取和自注意力机制,提出了一系列基于生成对抗网络的图像融合算法。

第一章 绪论

1.1 课题研究背景及意义

近些年来,随着计算机技术的飞速发展,信息量不断扩大,信息融合技术成为计算机领域的研究内容之一。图像融合作为信息融合的重要研究分支,是一种图像增强技术,旨在通过将包含同一场景的不同类型的传感器图像结合起来,获得一幅鲁棒性更好,信息更加丰富的图像[1],实现对场景更加全面,清晰的描述,从而开展进一步的处理和研究。同一类型的传感器图像仅能从一方面获取信息,而多类传感器图像可以更全面的获取场景信息,因此,融合技术在计算机视觉中起着越来越重要的作用。

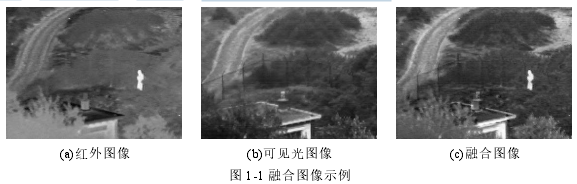

图像融合技术被应用于多个领域,包括多聚焦图像融合[2-4],红外与可见光图像融合[5-10],医学图像融合[11]和遥感图像融合[12-13]等。在本文中,主要的研究方向是红外与可见光图像融合,融合示例图如图 1-1 所示。红外与可见光图像融合是图像融合领域的一项重要课题,红外图像可以捕获到物体的热辐射信息,具有比较强的抗干扰能力,且可以容易的获取到场景中的红外目标,对于目标识别有着重要的作用,但图像的分辨率较低,丢失了大量的纹理细节信息,而可见光图像与之相反,可见光图像具有较高的图像分辨率,包含图像中大量的纹理细节信息和色彩信息,但是,这些图像容易受恶劣条件的影响,例如恶劣的天气和照明等,且容易丢失重要的目标,这两类图像可以提供具有互补属性的不同方面的场景信息,因此,红外与可见光图像融合的目标是整理这两类图像的特点,获得一幅信息丰富,红外目标清晰的融合图像[14],这对于目标识别[15],物体检测[16],图像增强[17]和监视[18]等都有着至关重要的作用。

图 1-1 融合图像示例

....................................

1.2 课题研究现状

在过去的几十年中,许多传统的图像融合方法被提出。Meng 等提出了一种结合目标区域检测和非下采样轮廓波变换(Nonsubsampled Contourlet Transform, NSCT)的红外和可见光图像融合算法,能够在融合图像中清晰地识别目标,保留细节和视觉信息[67]。Liu 等人提出了一种卷积稀疏表示(Convolutional Sparse Representation,CSR)的图像融合算法,该算法将图像分解为基本层和细节层,然后对其分别进行融合,最后相加得到融合图像[9]。Zhu 等人提出了一种基于改进的多尺度变换模型的图像融合方法,该模型可以增强源图像中目标的显著度,较传统的多尺度变换方法能够更好的保留源图像的细节[19]。Ma 等人提出了一种基于梯度转移和变化最小化(gradient transfer and total variation minimization,GTF)的红外与可见光图像融合算法,该算法得到的融合图像具有突出的红外目标和丰富的纹理细节信息[6]。

近年来,深度学习技术已广泛应用于各种计算机视觉任务,并在图像融合领域取得了显著效果。例如 Liu 等人提出了一种基于卷积神经网络(Convolutional Neural Network,CNN)的多聚焦图像融合算法,将多聚焦图像融合问题转化为基于卷积神经网络的二进制分类问题,在其第一阶段,根据图像块的模糊程度,对许多带有聚焦和未聚焦标签的小图像块进行分类器训练,然后由训练好的分类器预测标签图,最后通过基于该图的得分情况得到融合图像[3]。Li 等人提出一种基于密集连接卷积网络的红外与可见光图像融合算法(A Fusion Approach to Infrared and Visible Images,DenseFuse),该网络在训练阶段使用自编码器从 COCO 数据集中学习特征表示,然后将成对的红外和可见光分别输入到编码器中,以获取其对应的特征图,在每个特征通道上执行逐个元素的加权融合策略,最后将融合的特征图馈送到解码器中以获得最终的融合图像[20]。之后,Luo 等人提出了联合卷积自编码网络(joint convolution auto-encoder network,JCAE),通过设计双分支结构学习多聚焦图像的公共特征与聚焦区域映射,较好的融合了聚焦区域,获得自然清晰的视觉效果[66]。Zhang 等人提出了一种基于卷积神经网络的通用图像融合框架(Image Fusion Framework Based On Convolutional Neural Network, IFCNN),该框架基于卷积神经网络设计的,其中包含三个步骤,分别是特征提取,特征融合和特征重构,其中特征提取和特征重构采用的是卷积神经网络,而特征融合则采用手动设计融合策略,例如选择最大融合策略和加权平均融合策略,该算法在多聚焦、红外和可见光、多模态和多曝光上均取得了不错的结果[21]。

......................................

第二章 相关工作介绍

2.1 生成对抗网络

生成对抗网络(Generative Adversarial Networks, GAN)是由 Goodfellow 等人[22]于2014 年提出的,这在深度学习领域引发了极大的影响。GAN 具有两个模型,分别是生成模型和判别模型,生成模型用于生成样本,判别模型用于判别样本来自训练数据的概率。更具体的是,GAN 在生成器和鉴别器之间建立对抗博弈,噪声经过生成器生成一个样本,鉴别器区分该样本是真实样本还是生成的样本,依次进行下去,直到生成的样本无法被鉴别器区分为止,生成器就生成了质量比较好的图像样本。

原始的 GAN 可以很好的生成手写数字图像,但生成更高质量的图像仍存在很严重的噪声,另外一个问题就是训练不稳定,容易出现模式坍塌现象,针对以上问题,Radford等人提出了 DCGAN[25],将 CNN 首次引入到生成对抗网络中。原始 GAN 的生成器和鉴别器均使用的是全连接神经网络,无法训练出好的模型,而 DCGAN 的生成器和鉴别器使用的是 CNN,对于图像生成或者图像分类,都能起到更好的效果,因此适当设计 CNN的网络结构就可以使 GAN 的训练相对稳定,生成图像的图像质量更好,同时通过一系列技巧改进了原始 GAN,例如在鉴别器中应用跨步卷积来实现特征图的下采样,在生成器中使用跨步卷积来实现特征图的上采样,以及在生成器和鉴别器中添加了批归一化[26](Batch Normalization, BN)和线性整流函数(Rectified Linear Unit, ReLU)等。

.................................

2.2 显著度检测

自然场景中往往存在一些人类能够快速的关注到视觉上独特的区域,这些区域通常称之为显著性区域,而对这些区域进行检测和分割,被称为显著度检测。近些年来,显著度检测在计算机视觉领域引起了人们很多的关注,主要是因为图像中的显著性区域往往能代表该场景中最有效表示场景的区域,而显著度检测往往能检验出图像中的这部分区域,从而解决复杂的计算机视觉问题。

早期,Itti 等人受生物学启发,根据生物学中灵长类动物早期视觉系统的神经结构和行为特点,提出了早期显着性驱动的视觉焦点计算模型[34]。后来,对于显著性检测的研究越来越多,其中最具有代表性的是 Zhai 等人根据像素与所有其他像素的对比度来定义图像的显著性,该算法得到的显著度图比较稳定,效果也比较好[35]。Zhang 等人将该方法做了一些改进,提出了一种基于显着性分析的红外和可见光图像融合方法。该方法首先分解源图像,然后采用改进的显着性检测方法来检测红外图像的显着目标区域,从而确定基础层的融合策略权重,最后重建出融合图像,本文第三章内容使用的该方法得到的显著度图[36]。

近年来,深度学习不断发展,卷积神经网络由于其强大的自学习能力,成为了图像处理领域中的普遍工具,因此,基于 CNN 的显著性检测越来越多,其中最具有代表性的是 PAN 等人的基于生成对抗网络的显著性检测,该方法使用生成对抗网络进行显著性预测,在传统显着性预测中添加了高水平的对抗性损失,本文第四章内容使用的该方法得到的显著度图[37]。红外与可见光图像融合不仅要使融合图像获取到更多源图像的细节信息,还应该获取到源图像中的显著性区域,这样得到的融合图像的主观视觉效果才能更好,图像质量才能更高,故设计基于显著度提取的融合方法尤为重要。

.................................

第三章 基于弱监督生成对抗网络的红外与可见光图像融合方法 .................................... 13

3.1 弱监督的生成对抗网络 ........................................... 14

3.1.1 模型框架 ......................................... 14

3.1.2 网络结构 ..................................... 15

第四章 基于双鉴别器的红外与可见光图像融合方法 ................................ 23

4.1 双鉴别器的生成对抗网络 ................................... 23

4.1.1 模型框架 ......................................... 23

4.1.2 网络结构 ...................................... 24

第五章 基于自注意力机制的红外与可见光图像融合方法 ............................ 31

45.1 基于自注意力机制的生成对抗网络 ............................................ 31

5.1.1 网络结构 ..................................... 31

5.1.2 融合规则 ....................................... 32

第五章 基于自注意力机制的红外与可见光图像融合方法

5.1 基于自注意力机制的生成对抗网络

本节首先介绍了基于自注意力机制的生成对抗网络的网络结构,接着对自注意力引导的融合规则进行了详细的叙述,最后,对本章所使用的三个损失函数作进一步的描述。

5.1.1 网络结构

本章算法的网络架构主要由生成器和鉴别器两部分组成,它们的结构都是基于卷积神经网络设计的。

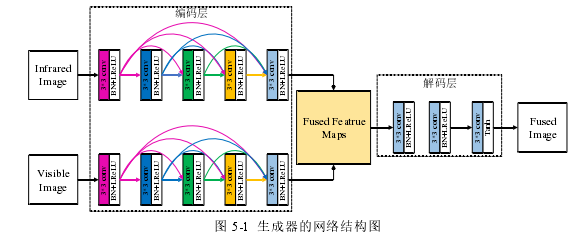

图 5-1 生成器的网络结构图

生成器的网络结构如图 5-1 所示,生成器由编码层,融合层和解码层组成。编码层包含红外图像分支和可见光图像分支,每个分支包括 5 个可训练的卷积层,卷积核大小为33,为了保留图像的细节信息,我们在编码器的前四个卷积层中添加了密集的短连接操作。融合层将编码层输出的特征图插入到三个可训练的卷积层中,其卷积核大小为11 ,并通过矩阵运算和 softmax 函数获得红外图像和可见光图像的注意力图,根据平均加权策略融合红外和可见光的特征图。解码层包含三个可训练卷积层,卷积核大小为33 。对于图像融合而言,每次下采样会丢失源图像中的细节信息[23],因此,我们的网络中只含有卷积层,而不进行下采样操作,故将每层的步幅设置为 1。除此之外,每个卷积层都使用批标准化[17]和 Leaky ReLU 激活函数,而最后一个卷积层使用 tanh 激活函数来输出融合图像。

...........................

第六章 总结与展望

6.1 总结

本文就“基于生成对抗网络的图像融合方法研究”这个课题进行了广泛的探索,结合显著性提取和自注意力机制,提出了一系列基于生成对抗网络的图像融合算法。本文的研究内容如下:

(1)阐述了图像融合的研究背景和意义,介绍了论文的主要研究内容和创新点。

(2)介绍图像融合相关工作,包括生成对抗网络,显著性提取,自注意力机制和密集连接神经网络,并对常见图像融合方法和评价指标进行了概括和总结。

(3)红外与可见光图像融合缺少真实的融合图像,为了设计更适合图像融合的生成对抗网络,提出了一种基于弱监督生成对抗网络的图像融合方法。为此,通过预训练的模型获得源图像的显著度图,然后将源图像的显著度图根据最大选择原则进行融合,融合后的显著度图充当鉴别器的真实图像,融合图像的显著度图充当鉴别器的虚假图像,最终通过对抗性学习,可以使融合图像包含更多的源图像中显著区域。为了提高融合质量,在网络结构中添加了密集连接卷积神经网络和损失函数中添加了感知损失。在 TNO数据集上的实验表明,在客观和主观评估方面,我们的方法更好地保留了红外图像中的热红外目标和可见光图像中的细节信息,并且优于最新方法。

(4)在显著度提取的基础上,基于生成对抗网络对多红外与可见光图像融合方法进行进一步的研究。现有的基于生成对抗网络的红外与可见光图像融合方法主要将可见光图像作为鉴别器的真实图像,这样会使得融合图像丢失大量红外图像中的红外目标和细节信息,为确保源图像同时包含可见光图像的细节纹理信息和红外图像的红外亮度信息,提出了一种基于双鉴别器的红外与可见光图像融合方法。首先对红外图像进行显著性检测,获取到红外图像中显著的区域,然后对其取反,获取到可见光图像中的显著区域,最后设计两个鉴别器分别鉴别源图像与融合图像中显著区域的差异,通过对抗性学习,可以使融合图像包含更多的源图像中显著区域。TNO 数据上的实验表明,提出的算法在客观和主观评价上优于当前主流红外与可见光图像融合算法,较好地保留了可见光图像的细节信息和红外图像的红外目标信息。

参考文献(略)