本文是一篇计算机论文,笔者认为文本风格迁移任务是NLP中一个较为新颖的研究方向,旨在将相同的文本内容信息嵌入到不同风格的句子中,使之可以面向不同的受众,提高信息的接受度,并增加语言的多样性。

第一章 绪论

1.1 研究背景及意义

人工智能作为一种引领未来的战略性技术[1],目前已成为人们关注的焦点,在金融、零售、交通、医疗、安防和教育等领域均得到了广泛的应用[2]。自然语言处理(natural language processing,NLP)是人工智能领域最重要的分支之一,着重研究人与计算机之间用自然语言进行有效通信的各种理论和方法,融合了语言学、计算机科学、数学等众多学科的知识。

用自然语言与计算机进行通信是人们长期以来追求的目标,具有重要的现实意义和理论意义。人们可以用自己最习惯的语言使用计算机,而无需再花大量时间和精力去学习各种不同的计算机语言;同时,计算机也可以对自然语言进行处理、表示和理解。随着深度学习的兴起,研究者们将大量深度学习相关的模型和方法应用到复杂的NLP任务中,如卷积神经网络(convolutional neural networks,CNN)、循环神经网络(recurrent neural network,RNN)、长短期记忆网络(long short-term memory,LSTM)等,以期望获得更好的解决方案。

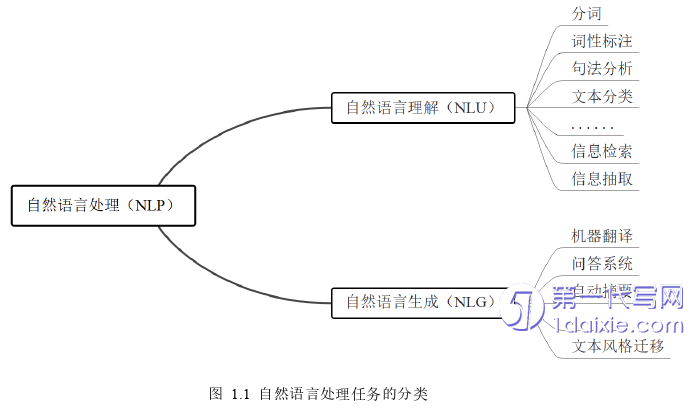

自然语言处理主要包括自然语言理解[3](natural language understanding,NLU)和自然语言生成[4](natural language generation,NLG)两大类。前者关注如何让机器更好地理解文本的含义,学会人类对待语言的思考过程;后者关注如何让机器更好地自动生成人们指定的文本,学会对文本进行修改与创作。各类研究包含的主要子任务如图1.1所示。

1.2国内外研究现状

“风格迁移”的概念于2015年最先由Gatys等人[11]在计算机视觉领域提出,他们使用CNN分别学习图像的内容特征和风格特征,通过处理高层抽象特征实现图像风格迁移,并获得了可观的视觉艺术效果。受此启发,Hu等人[12]首次提出了文本风格迁移(TST)任务,采用了变分自动编码器(variational auto-encoder,VAE)学习文本的潜在表示,并且利用一个风格分类器来学习文本的风格表示。Shen等人[13]针对不同风格的语料库共享文本内容的潜在语义分布,提出了交叉对齐自编码器(cross-aligned auto-encoder,CAAE)来学习风格迁移函数,实现内容和风格的分离。随后,Yang等人[14]提出一种与CAAE相似的方法,不同之处在于其判别器采用的是目标域的语言模型,可以为学习过程提供更丰富、更稳定的token级的反馈。由于生成对抗网络[15](generative adversarial network,GAN)模型在图像生成和风格迁移领域的成功应用[16][17],GAN也被引入TST领域。Fu等人[18]提出基于GAN的TST模型,旨在使用GAN分离文本中的风格信息。此外,受机器翻译领域回译[19][20](back-translation,BT)思想的启发,Prabhumoye等人[21]提出使用BT技术弱化文本中的风格信息,以达到分离文本中内容与风格的目的。Luo等人[22]引入强化学习思想,提出一种基于对偶强化学习的TST模型,使用一个特定的策略梯度算法[23]以最大化迁移后文本的预期奖励。

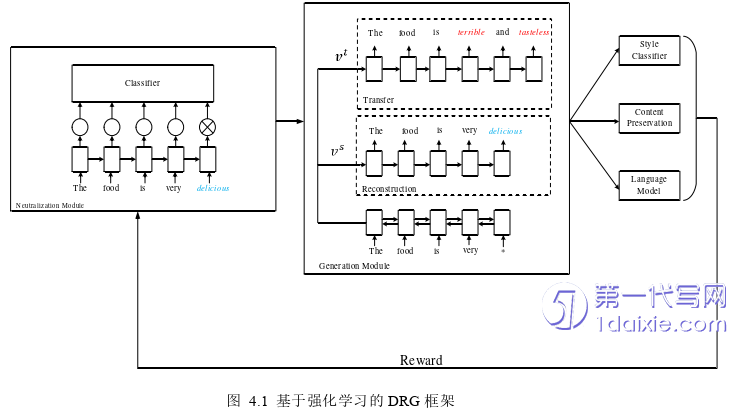

值得注意的是,以上的TST工作都是在隐空间(latent space)中将文本的内容特征向量与风格特征向量分离。除此之外,还存在另一类TST方法,即显式地分离文本内容和风格属性。这类方法认为,句子中的风格属性是由某些特定的词或短语所决定,因此,风格迁移时只需将这些词或短语转换成对应的风格属性即可,从而最大限度地保留文本的内容。Li等人[24]基于此思想,最先提出了“删除-检索-生成(delete-retrieve-generate,DRG)”的TST框架。在DRG框架的基础上,Sudhakar等人[25]使用了Transformer模型用来识别文本中的风格词进而转换文本的风格。Xu等人[26]则在DRG框架中引入了强化学习,来进一步促进模型更好地学习到文本内容和风格特征。

第二章 相关背景知识介绍

2.1文本表示模型

文本是一种由人类可以理解的字符和标点符号经逻辑组合产生的非结构化数据。在NLP中,最细粒度的文本就是词语,词语可以组成句子,句子再构成段落、篇章和文档。然而,计算机只能识别数字符号,因此首要工作便是将这类以词语为代表的自然语言进行数学上的表达,简单来说,就是将文本转化为计算机可识别的数值形式。目前,这种转化和表达的方式主要分为两种:基于离散表示的词袋模型和基于分布式表示的词嵌入模型。

2.1.1 词袋模型

文本的向量化离散表示是一种基于规则和统计的表示方式,目前最常用的方法为词袋(bag of words,BOW)模型。该模型以词之间保持独立性、没有关联为前提,将所有文本中的单词形成一个字典,然后根据字典来统计单词出现的频数。词袋模型的前身是One-Hot编码,即将每一个词表示为一维向量,其中向量的维度是文本所有词构成词集的数量。每个词的One-Hot编码为一个由0和1组成的向量,其中该词所在的位置设为1、其余位置设为0。One-Hot编码通俗易懂且易于实现,但可能造成数据过于稀疏,同时也未考虑词之间的相似关系以及词出现的频率,因此无法区分词的重要性。

词袋模型则是对One-Hot编码的进一步优化,先将文本中出现的单词构建成一个词典,再对每个句子中出现的单词进行词频统计,从而得到其对应于词典维度的向量表示。尽管词袋模型在一定程度上缓解了One-Hot编码的稀疏性问题,但依然没有包含文本的语法、语义信息,也丢失了词之间的顺序信息,如无法区分“我为你鼓掌”和“你为我鼓掌”两个语句。

随着神经网络登上NLP的舞台,基于分布式表示的词嵌入模型渐渐占据了文本表示方法的主导地位。

2.2预训练模型

在深度学习时代,为了充分训练深层模型的参数并防止过拟合,通常需要更多的标注训练数据。相比于CV领域,NLP领域的标注数据集规模较小,导致深度学习模型容易过拟合。因此,如果能够充分利用NLP领域中存在的大量无标注数据进行无监督地训练,则有望提升模型的泛化能力以及在下游任务中的表现。

预训练模型(pre-trained models,PTMs)的出现将NLP带入了一个全新时代。PTMs的核心思想是先在大规模无标注的数据集中预先学习到数据的特征分布,随后在下游任务上进行模型微调(fine-tuning)以获得更好的性能。在NLP领域中,预训练模型通常被称为预训练语言模型(pre-trained language models,PTLMs)。

谷歌公司的Devlin[41]等人受到语言模型嵌入[42](embeddings from language model,ELMO)、生成式预训练[43](generative pre-training,GPT)等方法的启发,提出了一个基于Transformer的双向编码表示(bidirectional encoder representations from Transformers,BERT)模型,如图2.2所示。该模型创新性地利用掩蔽式语言模型(masked language model,MLM)和下一句预测(next sentence prediction,NSP)两种方法来训练。MLM和NSP的思想十分相似,前者是随机地对文本中的一些句子进行替换,后者是对句子中的一些词进行替换,再利用周围的句子或词来预测被替换的部分,因此可以很好地学习句子之间和词之间的关系。

第三章 基于属性词删除新策略的DRG文本风格迁移方法 ................................... 23

3.1基于属性词删除新策略的DRG框架 ................................ 23

3.1.1 预训练属性分类器 ...................................... 24

3.1.2 属性词定位和删除策略 .......................... 25

第四章 基于强化学习的DRG文本风格迁移方法 .............................. 32

4.1基于强化学习的DRG框架 ........................ 32

4.1.1 中立模块 .......................................... 33

4.1.2 生成模块 .................................... 33

第五章 总结与展望 ........................................ 40

5.1工作总结 ....................................... 40

5.2 未来展望..................40

第四章 基于强化学习的DRG文本风格迁移方法

4.1基于强化学习的DRG框架

基于强化学习的DRG框架主要分为三个部分:中立模块、生成模块和奖励模块。其中,中立模块负责显式过滤属性词以提取文本内容;生成模块负责将目标属性添加到文本内容中,以进行文本风格迁移,生成所需的目标句子;奖励模块负责进一步优化中立模块和生成模块,以提升模型在迁移准确率、文本内容保留度和流畅度上的性能表现。

模型整体框架如图4.1所示。下面分别对每一个模块进行详细的介绍。

第五章 总结与展望

5.1工作总结

文本风格迁移任务是NLP中一个较为新颖的研究方向,旨在将相同的文本内容信息嵌入到不同风格的句子中,使之可以面向不同的受众,提高信息的接受度,并增加语言的多样性。本文首先对TST领域进行系统性的综述,随后提出两种基于DRG框架的文本风格迁移方法,并在多个公开的相关数据集上进行了实验,验证了模型的有效性。 本文开展的工作总结如下:

1. 本文梳理了已有的TST方法,根据训练数据是否为平行语料,将其分为基于监督学习的TST方法、基于半监督学习的TST方法和基于无监督学习的TST方法三类,重点介绍了基于无监督学习的TST方法,并对各类方法在实现机制、优势、局限性和性能等方面进行了分析和比较。

2. 为了更好地显式分离文本内容和风格属性,本文提出了一种新的属性词删除策略。该策略根据删除词前后属性分类器的概率变化来确定源句中需要删除的属性词。首先,预训练一个属性分类器;然后,根据删除策略定位并删除属性词,得到文本内容;接着,在目标域中检索与文本内容最相似的句子,并提取出目标属性词;最后,通过生成器生成符合目标属性的句子。实验结果表明,该方法在文本内容保留度上要优于基线方法,同时在迁移准确率和流畅度上也有不错的表现。

3. 为了提升生成目标句子的流畅性以及语法的连贯性,本文提出了一种结合强化学习的DRG文本风格迁移方式,通过加入语言模型奖励机制以优化模型在文本流畅度上的表现。在生成目标句子后,分别基于属性分类准确率得分、文本内容保留度得分和流畅度得分设计了三种奖励机制来促进模型进行更好的优化。实验结果表明,该方法在文本流畅度上有一定的提升,同时在迁移准确率和文本内容保留度上也获得很好的平衡。

参考文献(略)