本文是一篇计算机论文,本文对多智能体强化学习的剪枝方法应用进行了研究,证明了剪枝方法可以应用于多智能体强化学习领域,并提出了基于网络特征的分层剪枝方法NS-IPM。

第一章 绪论

1.1 研究背景和意义

多智能体系统(multi-agent system)是指多个智能体在同一个环境中进行自主决策和交流,它们可以有着相同的或不同的目标。如果多智能体的目标相同,它们就会采取合作行为来使利益最大化;如果目标不同甚至互相阻碍,它们则会采取竞争行为来超越对手。为了完成目标,智能体需要对其他智能体的行为和环境的状态有足够充分的理解。因此,智能体对自主学习和适应环境的能力有着极高的需求。在这种交互式场景下解决学习问题的最常见框架是强化学习(Reinforcement Learning)[1]。

自从深度学习方法取得了巨大突破后,强化学习领域也得到了充分的发展和广泛的关注。通过强化学习,人们完成了很多之前难以处理的任务,例如机器人[2,3]和游戏[4,5]。使用神经网络来逼近控制函数正是取得这些成就的关键。尽管强化学习在单智能体的环境中取得了巨大的成功,但在现实世界中,大量的应用场景都含有多个进行互动的决策者,例如分布式系统的协调[6,7]、自动汽车[8]、多机器人控制[9]、网络通信[10]等等。在这些场景中,每一个智能体都在公共环境里发展自己的策略,并根据其他智能体的状态和行为进行实时的改进。正因如此,多智能体强化学习领域受到了广泛的关注,并且重新涌现出大量的研究文献。

和单智能体环境相比,强化学习在多智能体的环境中的应用要面临更多的困难和挑战,尤其是“维度爆炸”(Curse of dimensionality)问题。由于每个智能体都有自己的状态和行为,而每一步的决策迭代往往需要对每个智能体的动作进行建模,这就会导致一个巨大的联合动作空间,尤其是在智能体数量较多时,计算量的巨大程度是难以想象的。

1.2 研究现状

本领域的研究现状可以从两部分介绍,一是多智能体强化学习领域的研究现状,二是神经网络模型剪枝领域的研究现状。

强化学习通常被大家认为是机器学习的一个分支。和传统的监督学习和非监督学习有所不同,在强化学习中,智能体与环境进行交互,并得到反馈。随着深度神经网络(DNN)的巨大成功,强化学习也焕发出新的生机,二者结合产生的深度强化学习(DRL)成功实现了对现实场景的复杂控制。单智能体的强化学习在机器人以及游戏上取得了巨大成功,例如Atari游戏集。目前,不少的多智能体强化学习算法都是由单智能体强化学习算法演化而来,例如MADDPG[22]。但是和单智能体相比,多智能体的强化学习面对着更多的困难和挑战。其中普遍被大家认同的问题主要包括:联合动作空间维度巨大、由于其他智能体策略改变导致的环境不稳定(non-stationary)、无法获得全局信息导致的对于环境的部分观测、以及如何确定每个智能体对于合作目标的贡献[1]。

针对上述的问题,多智能体强化学习领域的研究可以主要概括为两个主要方向:一是基于协作的算法研究,二是基于通信的算法研究。基于协作的算法主要研究内容是,如何通过集中式的训练来得到每个智能体的可独立执行的策略;基于通信的算法主要研究内容是,如何正确地处理从其他智能体得到的信息以及如何将自己对于问题的认知全面而有效地传递给其他智能体,通过建立通信机制来解决多智能体的同步和交流问题。多智能体强化学习是由单智能体强化学习延伸出的领域,这一定程度上导致了算法问题是研究的焦点,也使得优化神经网络参数的方法并没有得到足够的重视。

第二章 相关工作

2.1 单智能体强化学习

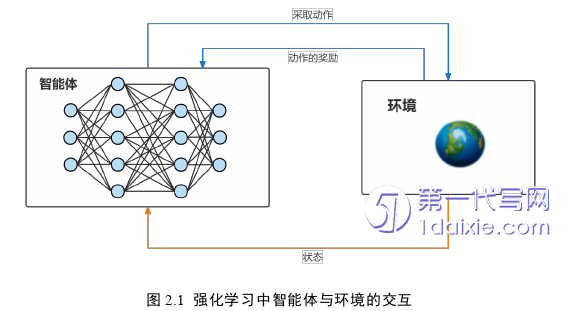

在强化学习中,智能体需要学习一种控制策略,所谓控制策略就是指,智能体可以根据自己的状态以及从环境得到的反馈来决定自己当前应该采取什么行为动作。如图2.1所示过程,智能体的目标就是通过与环境的交互来进行试错与改正,不断优化控制策略,以达到从环境中获得更多正向反馈的目标。

强化学习中最基础的框架就是马尔可夫决策过程(Markov decision process),其定义如下:

一个马尔可夫决策过程(MDP)可以由一个五元组(S,A,R,P,γ)来进行描述。其中S代表状态空间,𝑠𝑡∈S代表智能体在t时刻的状态;A代表动作空间,𝑎𝑡∈A代表智能体在t时刻采取的动作;R代表环境给予智能体的奖励, 𝑟𝑡∈p(𝑠𝑡,𝑎𝑡) 代表智能体状态 𝑠𝑡 采取动作 𝑎𝑡 所得到的即时奖励;P:S × A → P(S) 代表了状态转移概率分布,p[𝑠𝑡+1|𝑠𝑡,𝑎𝑡] 代表智能体在状态 𝑠𝑡 时采取动作 𝑎𝑡,可以从状态 𝑠𝑡 转移到状态 𝑠𝑡+1 的概率。γ代表折扣因子。

2.2 多智能体强化学习

2.2.1 马尔可夫博弈

多智能体系统是指多个智能体在同一个环境中进行自主决策和交流,它们可以有着相同的或不同的目标。为了完成目标,智能体需要对其他智能体的行为和环境的状态进行建模,并通过一种集中式的训练方式或者交流方式来进行互动。能否高效的适应环境并获得对其他智能体行为的充分理解是多智能体系统中的关键问题,因此智能体对自主学习的能力和适应环境的能力有着极高的需求。

当强化学习过程从单智能体变为多智能体后,建模过程也就演变为马尔可夫博弈(Markov Game)。马尔可夫博弈是对马尔可夫决策过程的扩展,它将多个马尔可夫决策过程构建为多个智能体在共享环境中的交互过程。

多智能体强化学习交互过程如图2.2所示,它可以用元组(N,S,A,P,R,γ)来描述,其中N = {1,…,n},n > 1,代表系统中的所有智能体的集合,对于智能体i∈N,将除它以外的所有其他智能体记为 -i = N / {i}。其他符号含义与单智能体环境中类似,但略有不同。S代表所有智能体观测到的状态集合。 A = A1 × … × An表示所有智能体的联合动作空间,Ai表示智能体i∈N的动作空间;转移概率函数P:S × A→P(A)描述了状态转移概率。每个智能体都拥有一个相关联的奖励函数Ri = S × A × S→R。最后,γ代指折扣因子。

在时间t,每个智能体i∈N根据自己的策略 π𝑖 :S→P(𝐴𝑖)选择并执行一个动作。当每个智能体接收到Ri作为状态转换的即时奖励时,系统从联合动作At下的状态st(相对于转移概率函数P)演化到下一个状态st+1。与单智能体问题类似,每个智能体的目标是不断改进自己的策略,以便最大化收到的长期奖励。

第三章 多智能体强化学习中的剪枝方法应用 ........................19

3.1 实验环境 ...................................19

3.2 剪枝方法 .......................................21

第四章 基于网络特征的分层剪枝方法的有效性验证 ...........................40

4.1 算法设计 ........................................40

4.1.1 网络深度 ..................................41

4.1.2 网络层宽 ...................................42

第五章 结论与展望 .....................................51

5.1 论文总结 ....................................51

5.2 工作展望 ..................................52

第四章 基于网络特征的分层剪枝方法的有效性验证

4.1 算法设计

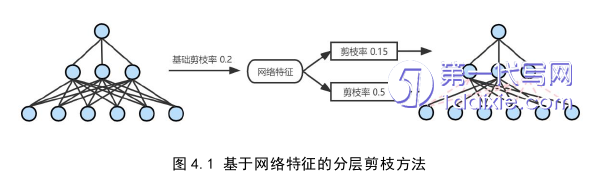

基于网络特征的分层剪枝方法NS-IPM采用非结构化的迭代剪枝流程。为了充分利用已训练网络的结构特征信息,研究网络特征对于剪枝过程的影响,算法分别从三个方面进行实验与研究:网络的深度,每一层的宽度以及层间重要性评估。

4.1.1 网络深度

AutoLR中的研究表明,网络每一层参数对于特征的提取具有不同的特点[38]。即低层(靠近输入端)会提取相对通用的特征,而高层(靠近输出端)会提取针对于任务的特征。

他们做了一组对比实验,实验采用的是训练好的Resnet网络,分别将完整网络和移除了最高两层的网络,直接迁移到其他类似的数据集中去测试,发现移除了最高两层的网络明显优于之前的完整网络。说明高层提取的特征对于之前的特定任务是很重要的。

他们还发现,网络底层的权重变化水平要明显大于高层的,并且随着训练,每一层的变化率也在减小。他们的实验采用Resnet-50网络,第一层的权重变化率可以达到最后一层的十几倍以上。也就是说,在底层的权重更容易实现从小变大,权重在某个时刻的重要性更有可能会在下一时刻突然翻转。

第五章 结论与展望

5.1 论文总结

近年来,多智能体强化学习(MARL)领域得到了蓬勃发展,例如AlphaStar、OpenAI FIVE、绝悟等都是领域内重要的突破。尽管成绩斐然,但多智能体强化学习仍面对着一些严峻的挑战,如联合动作空间维度巨大、由于其他智能体策略改变导致的环境不稳定(non-stationary)、仅能获得环境的部分观测时的训练问题等。其中,由于联合动作空间维度导致的计算量巨大的问题犹为关键。

与此同时,Yu等人[17]证实了模型剪枝方法可以应用于单智能体强化学习领域,并且取得了不错的效果。受此启发,本文将剪枝方法与多智能体强化学习场景相结合,分别采用全局剪枝方法和传统分层剪枝方法,在基于《星际争霸2》的强化学习框架SMAC上进行实验。同时,针对全局剪枝方法在进行到剪枝过程后期时,网络模型的准确率会随网络结构失衡陡然下降的问题以及传统分层剪枝方法对于网络特征信息利用不充分的问题,提出了基于网络特征的分层剪枝方法NS-IPM。实验结果表明,剪枝方法可以有效减少多智能体网络模型的参数量,并且可以保持良好的表现。

但是作为一种剪枝方法,NS-IPM的有效性仍需在图像处理领域进行验证。为此,我们在图像识别数据集CIFAR-10上进行实验,采用VGG-16和Resnet-20作为网络模型,将NS-IPM分别与全局剪枝方法和传统分层剪枝方法进行对比。实验结果表明,基于网络特征的分层剪枝方法在VGG-16模型上表现良好,在压缩率高出接近一倍的情况下,准确率仍比单剪枝率的分层剪枝方法高3.6%,且整体表现优于全局剪枝方法。当压缩率到达98.85%以上时,在Resnet-20模型上的准确率比单剪枝率的分层方法高20%,接近于全局剪枝方法。

参考文献(略)